Auch hier im zweiten Teil der Folge (siehe auch 1. Teil) soll Überblick bedeuten, dass nur die wichtigsten und die von Microsoft selbst angebotenen Dienste in meinen Ausführungen berücksichtigt werden.

Zum Sammelbegriff Data Lake, welcher bei Microsoft für Big Data steht, sortieren sich in Azure die Dienste Data Lake Store und Data Lake Analytics sowie HDInsight ein. Die weiteren Dienste decken dann die Felder IoT/IIoT, Analysen in verschiedenen Ausprägungen sowie Datenhaltung und Verwaltung.

|

Die betrachteten Dienste sind im Einzelnen:

|

-

HDInsight

Cloudbasierte Hadoop-, Spark-, R Server-, HBase- und Storm-Cluster -

Machine Learning

Predictive Analytics-Lösungen erstellen, bereitstellen und verwalten -

Stream Analytics

Echtzeitverarbeitung von Datenströmen von Millionen von IoT-Geräten -

Data Lake Store

Riesiges Repository für Big Data-Analyseworkloads -

Data Lake Analytics

Verteilter Analysedienst zur vereinfachten Analyse von Big Data -

Azure Analysis Services

Datenanalysen in der Cloud -

Azure Data Catalog

Verwalten von Unternehmensdatenbeständen

|

Dies heißt nun im Detail:

|

-

HDInsight – Cloudbasierte Hadoop-, Spark-, R Server-, HBase- und Storm-Cluster

HDInsight bringt die bekannten Apache Open Source Big Data und Analyse-Technologien wie Hadoop, Spark, Hive, MapReduce, HBase, Storm und Kafka, sowie den Microsoft R Server in die Microsoft Cloud und basiert auf einer Distribution der Hadoop-Komponenten der Hortonworks Data Platform (HDP).

HDInsight wird in verschiedenen Clusterversionen angeboten, die die verschiedenen HDP-Versionen von 2.1 bis aktuell 2.6 abbilden, die unter Linux und Windows implementiert sein können. Die Implementierung unter Windows läuft allerdings aus und neue Versionen und Updates werden nur noch unter Linux angeboten.

Mit einer SLA von 99,9 % und dem Support rund um die Uhr, ist HDInsight mit verschiedenen Replikationsmethoden für vollständige Redundanz und hohe Verfügbarkeit und Ausfallsicherheit ausgelegt.

Über die getrennte Belegung von Storage und Compute-Leistung, lässt sich der Dienst je nach Workload angepasst und kosteneffizient skalieren. Allerdings verursacht ein einmal eingerichteter Cluster zeitabhängige Kosten, ob er genutzt wird oder nicht. Der Dienst HDInsight steht auch in der besonders verwalteten Azure-Region in Deutschland zur Verfügung.

-

Machine Learning – Predictive Analytics-Lösungen erstellen, bereitstellen und verwalten

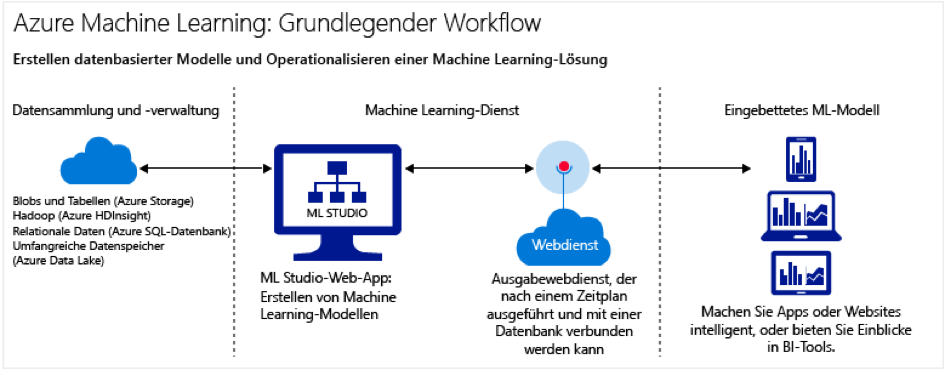

Mit Azure Machine Learning (AML) stellt Microsoft einen cloudbasierten Dienst für Predictive Analytics oder Data Science Anwendungen zur Verfügung. Bereitgestellt wird neben dem eigentlichen Dienst, eine große Algorithmen-Bibliothek, eine Studio-Komponente zum Entwickeln, Testen und Verfeinern von Modellen sowie eine einfache Möglichkeit, die erstellten Modelle als Webdienst zu veröffentlichen.

Herzstück ist das AML Studio, in dem die Vorhersagemodelle relativ schnell erstellt, getestet, operationalisiert und verwaltet werden können. Das Studio bietet eine umfangreiche Bibliothek mit Machine Learning-Algorithmen und -Modulen, sowie viele Beispielexperimente und R- und Python-Pakete. Unterstützt werden außerdem auch benutzerdefinierte R- und Python-Skripte.

Über das AML Studio werden die Modelle als Webdienste veröffentlicht, sodass sie von benutzerdefinierten Apps oder BI-Tools genutzt werden können. Zum Testen oder Ausprobieren steht zur Nutzung des Studios eine kostenlose Version mit eingeschränkten Funktionalitäten bereit. Sonst wird nach Benutzer pro Monat und Zeit berechnet.

Für die Veröffentlichung der Modelle, oder hier Experimente genannt, die über einen Webdienst bereitgestellt werden, sind verschiedene Tarife verfügbar. Und, der Dienst wird auch in der Deutschland-Cloud mit entsprechender Datenhoheit und zusätzlichen Sicherungs- und Datenschutzstufen angeboten.

-

Stream Analytics – Echtzeitverarbeitung von Datenströmen

Real Time Analytics für Streamingdaten designet für IoT/IIoT so ließe sich der Dienst Azure Stream Analytics am kürzesten beschreiben. Vergleichbar der Analyseplattform Apache Storm, welche ja auch über HDInsight in Azure angeboten wird, ist Stream Analytics als PaaS-Lösung verfügbar. Als Quelle mit Streamingdaten für Stream Analytics kann ein Azure Event Hub oder IoT Hub direkt verwendet werden. Die Daten können aber auch aus einem Datenspeicher, wie z.B. einem Azure Blob Storage, abgerufen werden.

Zum Untersuchen des Datenstroms lässt sich ein Stream Analytics-Auftrag erstellen, in dem angegeben ist, woher die Daten stammen und wie nach Daten, Mustern oder Beziehungen gesucht werden soll. Für diese Aufgabe unterstützt Stream Analytics eine SQL-ähnliche Abfragesprache, mit der sich die Streamingdaten für einen bestimmten Zeitraum filtern, sortieren, aggregieren und zusammenführen lassen. Schließlich ist im Auftrag auch noch der Ausgabeort angegeben, an den die transformierten Daten gesendet werden. So lässt sich steuern, was als Reaktion auf die analysierten Informationen zu tun ist. Beispielsweise können Warnungen ausgelöst, Informationen an ein Berichtstool wie Power BI geschickt oder Daten zur späteren Untersuchung gespeichert werden.

Gegenüber der oben erwähnten Analyseplattform mit Apache Storm ergeben sich für Stream Analytics eine Reihe von Vorteilen. So die bessere Integration in Azure, die verwendete Abfragesprache mit einem Subset von T-SQL und letztendlich die Kostenstruktur. Denn, der Dienst wird nutzungsbasiert auf Grundlage der Menge an verarbeiteten Ereignissen und dem Umfang der im Cluster bereitgestellten Rechenleistung abgerechnet. Im Gegensatz zu dem bereitgestellten Cluster wie bei HDInsight bzw. Apache Storm. Stream Analytics wird mittlerweile auch in der Deutschland Cloud von Microsoft angeboten.

-

Data Lake Store – Riesiges Repository für Big Data-Analyseworkloads

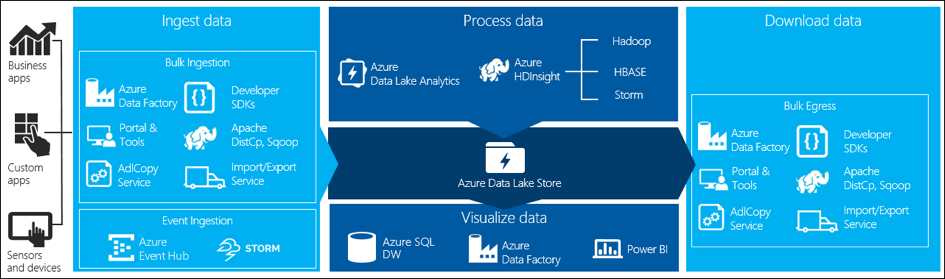

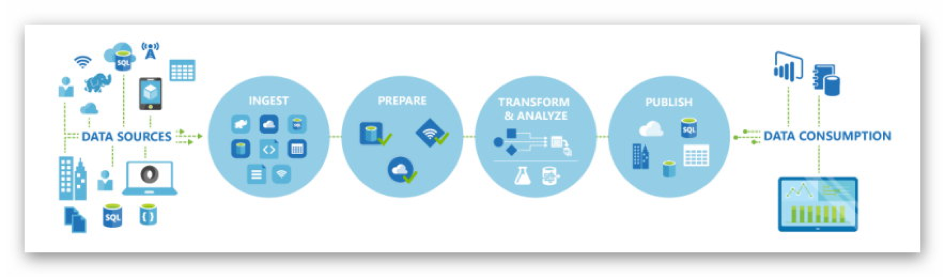

Der Azure Data Lake Store ist ein hochgradig skalierbares Repository, das für Big Data-Analyseworkloads optimiert ist. Der Data Lake Store bietet eine Basis für unternehmensbezogene Big Data Anwendungen. Und dies mit der Unterstützung für die Erfassung, Verarbeitung und Analyse sowie die Auswertung und Visualisierung von strukturierten, teilweise strukturierten und unstrukturierten Daten.

Neben der Unterstützung von verschiedenen APIs, SDKs und Schnittstellen, ist der Data Lake Store als Dienst in Azure integriert, sodass andere Azure-Dienste wie HDInsight, Data Lake Analytics, Stream Analytics, Data Factory usw. den Store als Repository sowie Datenquelle und Senke verwenden können. Mit HDInsight öffnet sich dabei die Hadoop und Apache-Welt und mit der Azure Data Factory (salopp gesagt) alles andere.

Die Kosten des Dienstes hängen von der Menge der gespeicherten Daten, vom Volumen und Größe der Transaktionen sowie den ausgehenden Datenübertragungen ab. Durch die Verbindung mit den anderen Azure-Datendiensten wie zum Beispiel der Data Factory und Tools wie dem im SQL-Server integrierten Polybase bieten sich nahezu unbegrenzte Möglichkeiten für alle Arten von Big Data Anwendungen. Es wird daher eher schwierig, die geeignetsten Dienste und Architekturen zu identifizieren. Und, leider steht der Data Lake Store (noch?) nicht in der nach dem Datentreuhändermodell verwalteten Cloud von Azure in Deutschland zur Verfügung, sondern für Europa bisher nur in der Region Nordeuropa (Irland).

-

Data Lake Analytics – Verteilter Analysedienst zur vereinfachten Analyse von Big Data

Der Azure Dienst Data Lake Analytics bietet eine Schnittstelle zur Ausführung von Programmen zur Verarbeitung, Transformation und Analyse von Big Data und Daten im Data Lake Store. Unterstützt werden (z.Zt.) die Sprachen U-SQL, R, Python und .NET. U-SQL stellt hierbei eine Abfragesprache da, bei der die bekannte deklarative SQL-Sprache mit den Ausdrücken von C# kombiniert wird.

Entwickeln lassen sich die U-SQL Anwendungen über bereitgestellte Tools in Visual Studio. Ausführen lassen sich die entwickelten Anwendungen wie z. B. Analysen, ETL-Strecken, Abfragen, Machine Learning u.ä. je nach Workload hochgradig parallelisiert bei einer dynamischen Skalierung in der Cloud. Es wird dabei nur die in Anspruch genommene Verarbeitungsleistung nach Minuten berechnet.

Der Dienst ist für die Arbeit mit dem Azure Data Lake optimiert. Er kann aber auch mit dem Azure Blob Storage und der Azure SQL-Datenbank kombiniert werden. Allerdings gilt auch hier, wie beim Data Lake Store, dass der Dienst (noch) nicht in der besonders verwalteten und geschützten Cloud in Deutschland zur Verfügung steht.

-

Azure Analysis Services – Datenanalysen in der Cloud

Die Azure Analysis Services ist eines der jüngsten Dienste in Azure und befindet sich noch in der Preview-Phase. Während der bereits genannte Dienst Azure Data Lake Analytics gezielt auf den Azure Data Lake und damit auf Big Data Analysen mit hohem Workload ausgerichtet ist, ist der neue Dienst Azure Analysis Service eher ein Pendant zum SQL Server Analysis Service (SSAS). Und hier für die Cloud mit Anbindung an lokale Datenquellen und bekannte Clientanwendungen wie Power BI, Excel und die Reporting Services. Da der Dienst von den Analysis Services des SQL Server abgeleitet ist, ist er auch mit vielen Features aus der SSAS Welt kompatibel. Zusätzlich arbeiten die Azure Analysis Services mit vielen anderen Azure-Diensten zusammen und ermöglichen so die Erstellung komplexer Analyselösungen, Nicht nur für die Cloud, sondern auch für hybride Datenmodelle.

Die tabellarischen Datenmodelle können direkt über das Azure-Portal erstellt werden oder aus vorhandenen Datenmodellen aus SSAS in den Dienst migriert werden. Hybride Datenmodelle können über lokale Datengateways angebunden werden. Auch ist der Dienst in die SQL Server Data Tools für Visual Studio und das SQL Server Management Studio angebunden und integriert. Die Erstellung, Verwaltung und Bereitstellung der Datenmodelle erfolgt daher nahezu identisch wie auf einem lokalen Server mit SSAS auch.

Wie erwähnt, befindet sich der Dienst noch in der Preview-Phase und wird noch laufend ausgebaut, was auch die unterstützten Datenquellen betrifft. Die Liste der unterstützten lokalen Datenquellen ist schon recht lang, während sie sich für die Cloud-Datenquellen derzeit noch auf die Azure Blob Storage, die Azure SQL Datenbank und das Azure Data Warehouse beschränkt.

Je nach erforderlicher Verarbeitungsleistung, QPUs (Query Processing Unit) und Speichergröße, werden verschiedene Tarife und Preismodelle angeboten. Der Dienst wird bereits in beiden europäischen Regionen (Norden und Westen) angeboten, allerdings noch nicht in der Deutschland-Cloud.

-

Azure Data Catalog – Verwalten von Unternehmensdatenbeständen

Der Azure Data Catalog ist ein vollständig verwalteter Dienst, der als Repository und Metadatenspeicher für die verwendeten Unternehmensdatenquellen dient. Bedingt durch die Cloud und in Anbetracht der derzeit rasant steigenden Anzahl an Datenquellen und Assets, hybride Datenmodelle, IoT und dergleichen, eine nahezu erzwungene Notwendigkeit.

Somit können sämtliche Benutzer von Analysten über Data Scientists bis hin zu Entwicklern Datenquellen und Assets registrieren, ermitteln, verstehen und nutzen. Im Daten-Katalog können Kommentare und Metadaten gesammelt werden, um nicht dokumentiertes Wissen zu erfassen. Sie bringen Licht ins Dunkel der verwendeten Daten und Datenquellen und ermöglichen somit einen zentralen Zugriff auf dieses Wissen.

Im Allgemeinen werden der Name, Typ und Beschreibung der Datenobjekte sowie Namen, Datentyp und Beschreibung von Attributen und Entitäten neben den spezifischen Eigenschaften (je nach Datenquelle) gespeichert. Zusätzlich ist es möglich, Beispieldatensätze und aggregierte Informationen wie zum Beispiel die Größe von Tabellen oder Mindest-, Höchst- oder Durchschnittswerte mit abzuspeichern. Außerdem die Informationen, wie auf die registrierten Datenassets zugegriffen werden kann.

Der Dienst wird in einer kostenlosen Edition mit einer Verwaltung von bis zu 5.000 Objekten angeboten. Darüber hinaus fallen Kosten pro Benutzer und Monat an. Ähnlich wohl aller neuen Dienste, steht der Datenkatalog noch nicht in der deutschen Cloud zur Verfügung sondern zunächst nur in Europa Nord und West.

Auch in diesem zweiten Teil könnte jeder einzelne aufgezählte Service locker einen eigenen Artikel oder ganze Bücher füllen. Auch sei nochmals darauf hingewiesen, dass die Entwicklung in und für Azure auch wegen Microsofts Devise Cloud first sehr dynamisch ist und daher dieser Artikel nur ein zeitliches Abbild geben kann.

Die Verfügbarkeit in der besonders verwalteten Azure-Region in Deutschland wird zum Beispiel noch zunehmen sowie einzelne Funktionen und Kompatibilitäten sowie die Integration der Dienste ebenfalls.